Recordemos que uno de los procesos clave en SEO es el rastreo. En este proceso, Google envía sus robots a analizar el contenido de nuestro sitio web. El análisis de logs es pues relevante, pues nos permite comprender qué bots de Google visitan nuestra web, con qué frecuencia, qué archivos o páginas consultan, y qué respuesta están obteniendo por nuestra parte. Mediante esos accesos, detectan URLs nuevas o bien contenidos modificados en páginas que ya estaban en su índice. Además, cada web tiene una frecuencia y volumen de rastreo limitados (crawl budget), así que nos interesa y mucho entender qué archivos visita y qué encuentra cuando los rastrea.

En este post encontrarás:

1. ¿Qué son los logs?

Una definición conceptual sería “un registro oficial de eventos durante un rango de tiempo en particular que se emplea para registrar los datos o información sobre quién, qué, cuándo, dónde y porqué un evento ocurre” (

ver wiki). En el caso que nos ocupa, son los

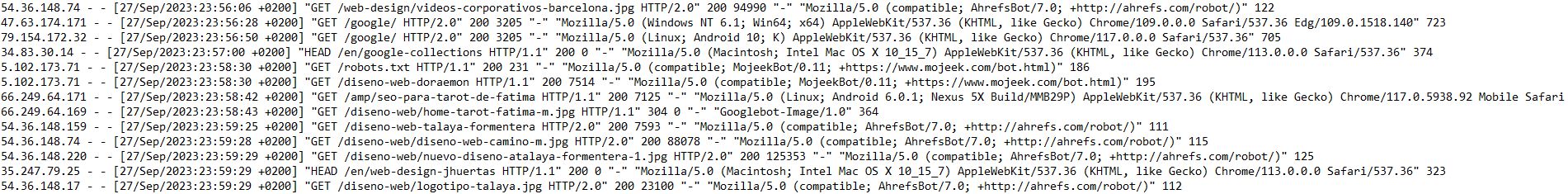

registros de visitas de los robots como los de Google a archivos de nuestro servidor web. Estos registros generan un archivo de texto de todas esas peticiones, que nosotros extraeremos para analizar. En el archivos de logs hay peticiones de muchos agentes, también de los usuarios, pero nuestra intención será obtener sólo aquellos que nos interesen para SEO.

Anatomía de un registro de log:

- IP: dirección en Internet del usuario que nos consulta

- Fecha: momento exacto de la consulta y su zona horaria

- Tipo de solicitud (GET, POST)

- URI: el recurso solicitado

- Protocolo: HTTP1, 2 o 3

- Código de respuesta que le devuelve el servidor: 200, 3XX, 4XX y 5XX…

- Tamaño el archivo (peso)

- user agent: qué usuario es y con qué navegador nos consulta

En definitiva, vemos quién consulta qué, a qué hora, cuánto pesa, y qué le ha devuelto nuestro servidor.

No obstante este formato de logs es el más común, para un servidor Apache, pero si usas otro tipo de hosting es posible que los archivos difieran un pelín en su estructura.

¿Cómo se obtienen los registros de logs?

Todo hosting decente, con sistemas PLESK, CPANEL o similares, deberá ofrecerte la opción de descargar esos archivos. En el caso de que no lo haga, solicítalo a tu proveedor de hosting y de paso ve pensando en

cambiar de servidor. Una alternativa, en caso de que tengas acceso a FTP, es consultar desde allí la carpeta /logs/.

2. Herramientas para el análisis de logs

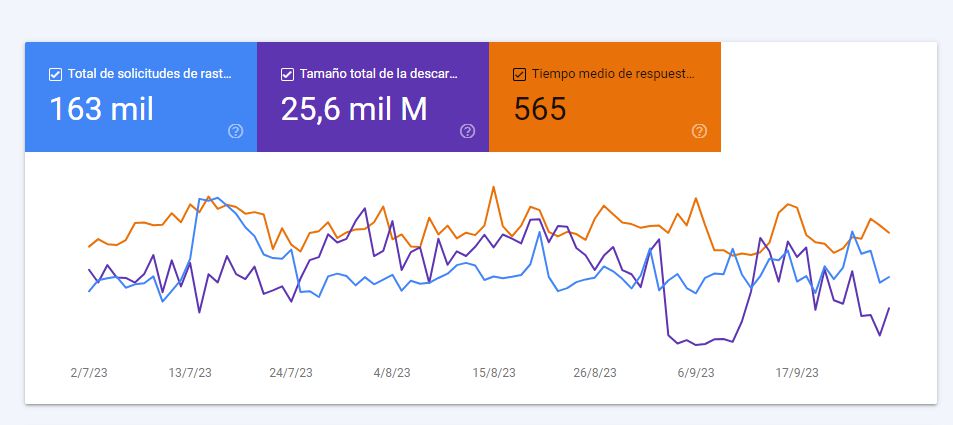

Crawl Stats de Google Search Console

La primera aproximación al análisis de logs de cualquier SEO debe ser este apartado de Search Console, que hemos visto ya en nuestra

Guía de Search Console.

Algunas informaciones interesantes que puedes obtener son:

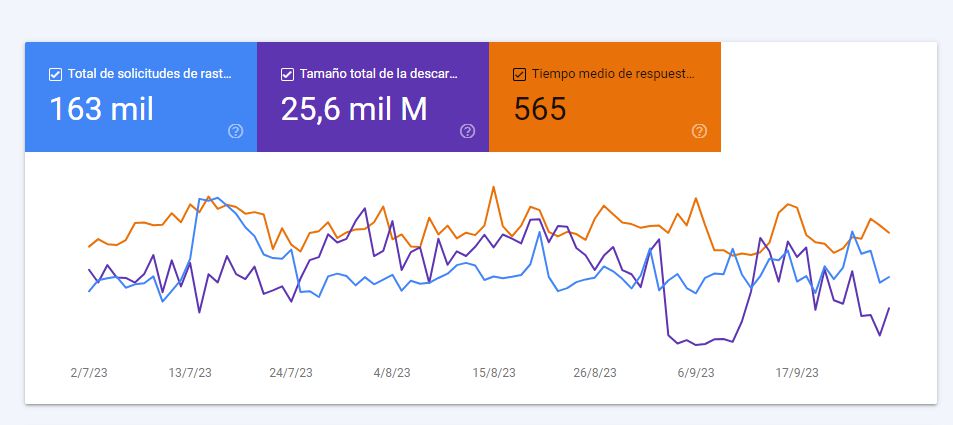

- Total de solicitudes de rastreo (ojo, sólo tiene en cuenta el robot que visita tu web de forma más habitual, normalmente el de Smartphone)

- Tamaño total de la descarga

- Tiempo medio de respuesta del servidor a la petición

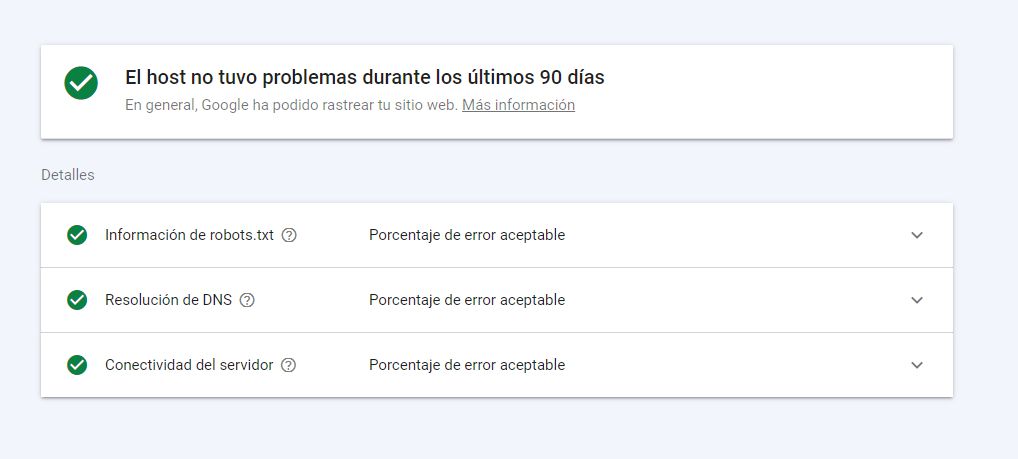

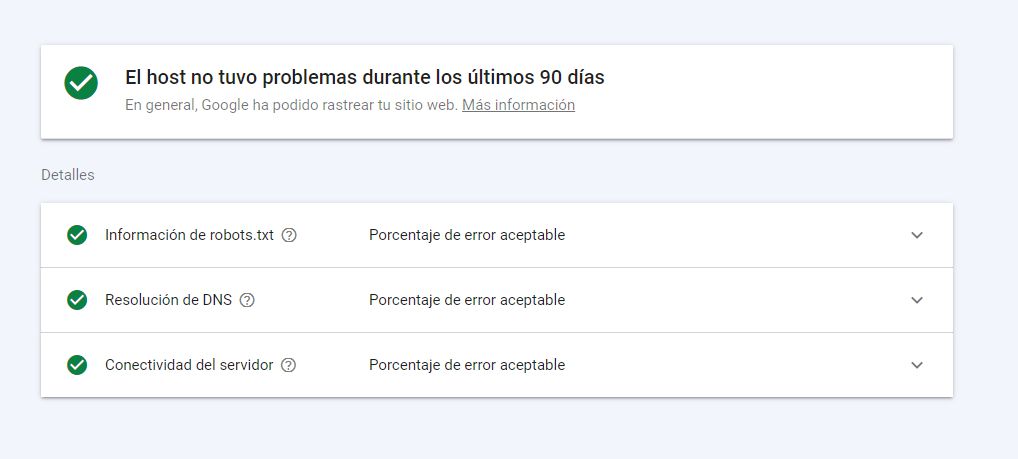

El estado del host es algo que en un 99% de ocasiones estará bien, pero si no es así, estamos ante un escenario grave: Google no ha podido consultar nuestra web en más de una ocasión, y deberemos tomar medidas. Siempre hay un porcentaje de error, pero no debemos superar nunca el umbral de error que se considera como aceptable.

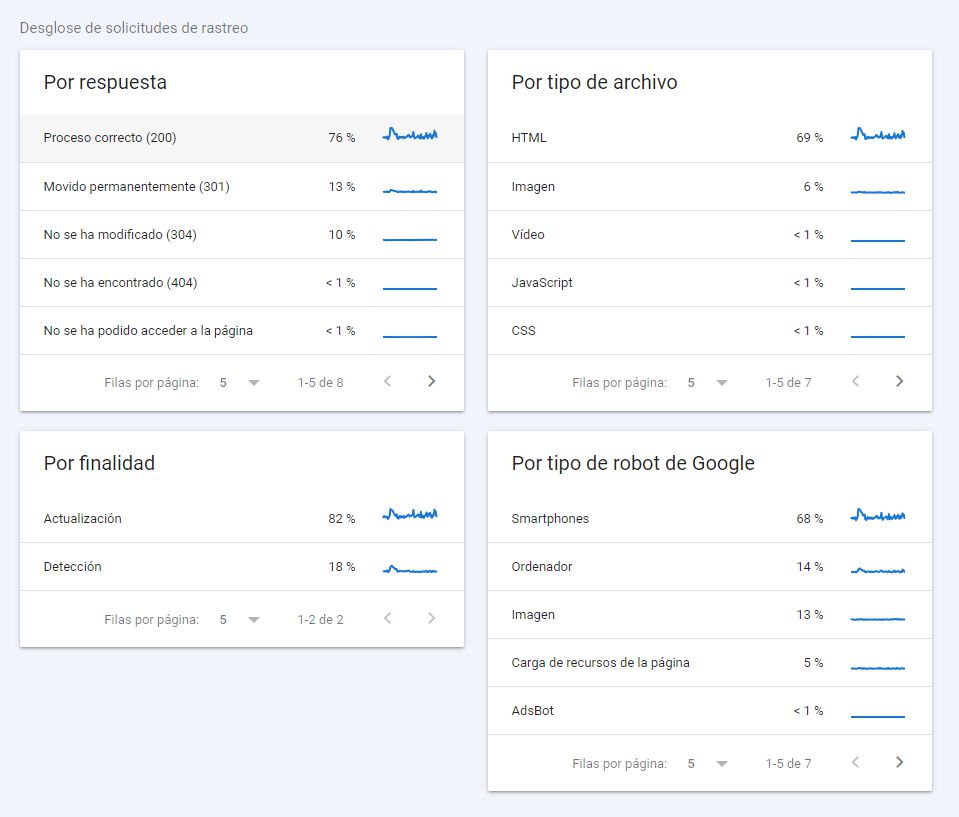

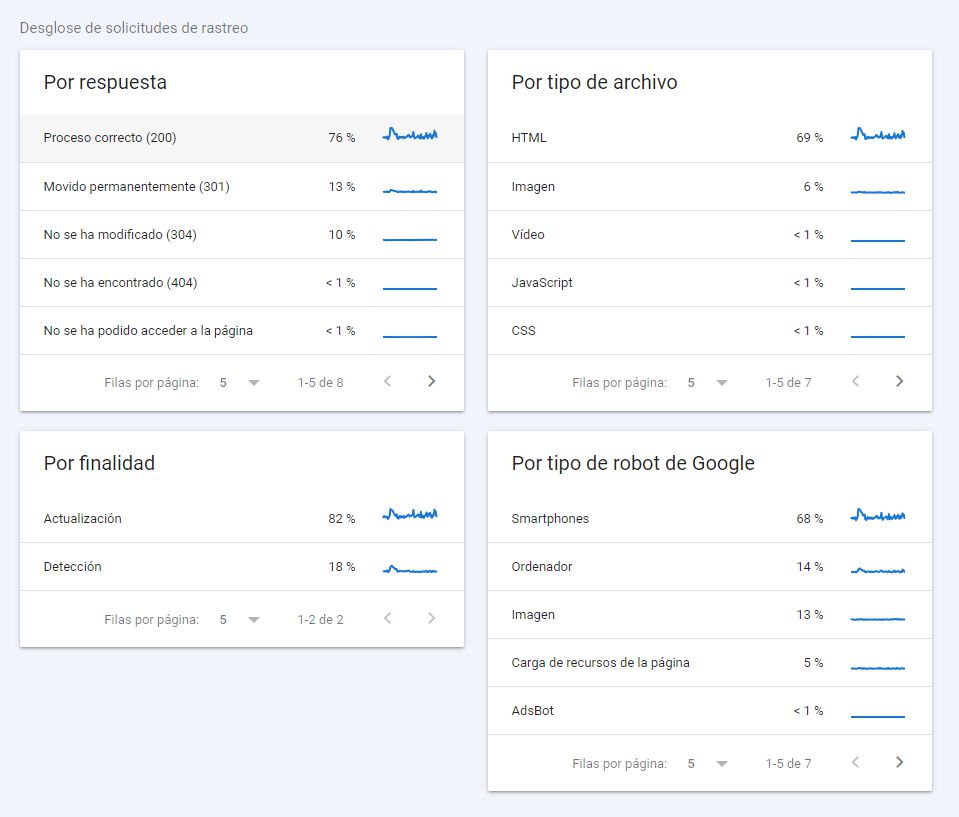

En el desglose de solicitudes de rastreo tenemos información muy relevante:

- Qué respuesta de servidor estamos entregando (cuantos más 200, mejor)

- Por finalidad (renovación o detección): dependerá del tamaño de nuestra web y nuestra frecuencia de publicación y actualización de contenidos

- Por tipo de archivo: lo ideal dado que estamos entregando web, es que en su gran mayoría detecte HTML. Aunque esto no te va a ocurrir con tecnologías de base JS, y en esos deberías analizar con detalle los procesos de renderizado

- Por tipo de robot: el tipo de contenido y la tipología de dispositivos de visita habituales condiciona a menudo estos datos

Sin duda la información básica sobre el análisis de logs ya lo podemos obtener a través del apartado de análisis de rastreo de Google Search Console.

Para webs pequeñas esto debería ser suficiente para hacerte una idea de qué le pasa a los bots de Google con tu sitio.

Screaming Frog Log Analyzer

Pero para webs grandes es muy recomendable monitorizar logs, y en ese caso Search Console queda cortísimo, pues nos da datos limitados, no manipulables y sólo de los últimos 90 días. Si estás en este segundo escenario entonces necesitas un software de análisis de logs, que te permita realizar un análisis en profundidad y una posterior

monitorización del crawling.

Hay varias herramientas en el mercado, pero por calidad-precio nosotros sin duda te recomendamos probar la

Screaming Frog Log Analyzer. Si conocéis a la rana de Screaming, su versión más conocida lo que hace es una simulación sobre cómo los bots de Google pueden analizar nuestro sitio. Pero con la SFLA lo que realizamos es un análisis eficiente de los logs que se han producido realmente.

Realizando un análisis de Logs con SFLA

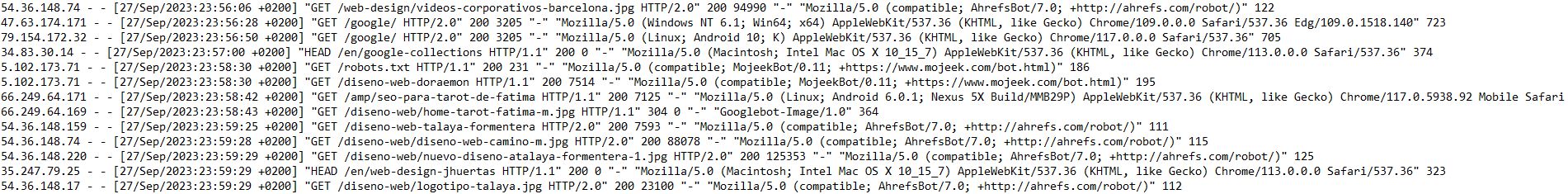

En el primer apartado hemos definido cómo obtener un archivo de logs. Ya tenemos esta preciosidad con nosotros, no te asustes:

Una vez obtenemos este archivo, el objetivo será

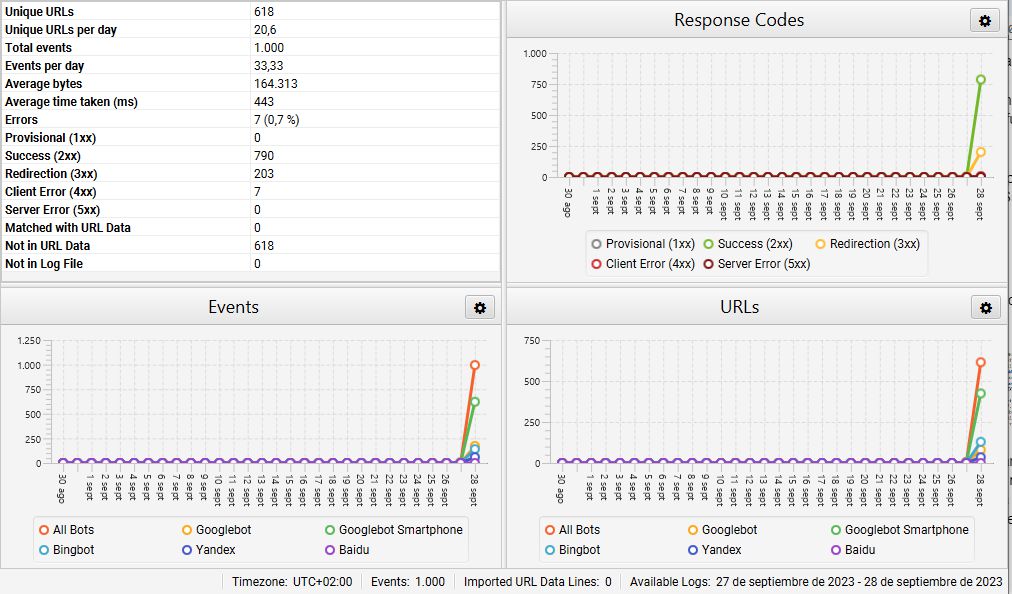

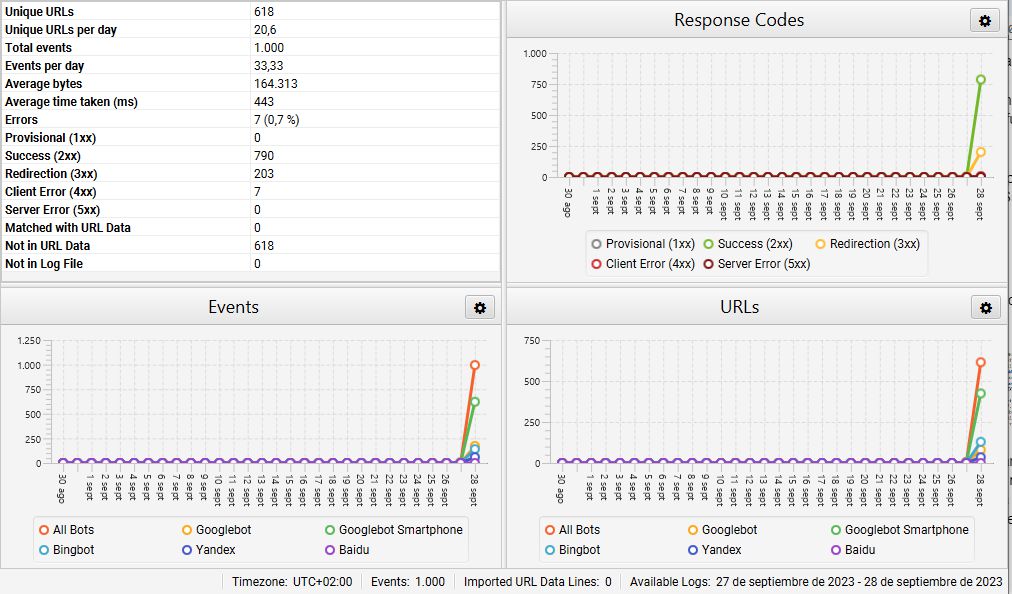

filtrar para obtener sólo los logs que nos interesan. Este proceso lo podríamos hacer manual, pero no te lo aconsejamos. En este ejemplo vamos a usar Screaming Frog Analyzer. Vamos a realizar este ejemplo con la versión gratuita, que coge una muestra de hasta 1.000 líneas. Subimos el archivo y obtenemos algo similar a:

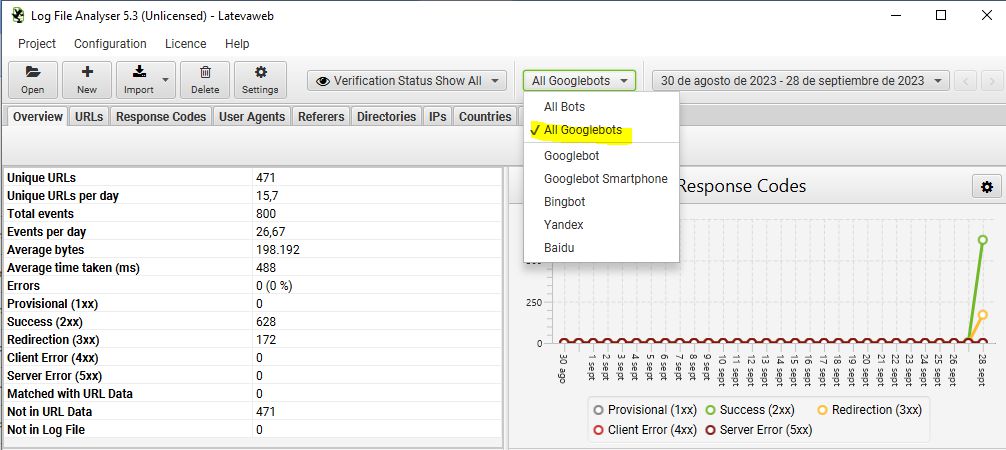

En este primer vistazo vemos que de los 1.000 registros la gran mayoría son de Googlebot Smartphone y Googlebot (el 80% conjuntamente), pero ojo, también hay visitas de los bots de Bing, Yandex y Baidu. también obtenemos una primera vista sobre qué código de respuesta estamos devolviendo. Este proyecto está muy trabajado, y no es casualidad que entregue en un 80% una respuesta 200, en un 20% redirecciones 3XX, y ninguna respuesta 4xx o 5xx, las más nocivas.

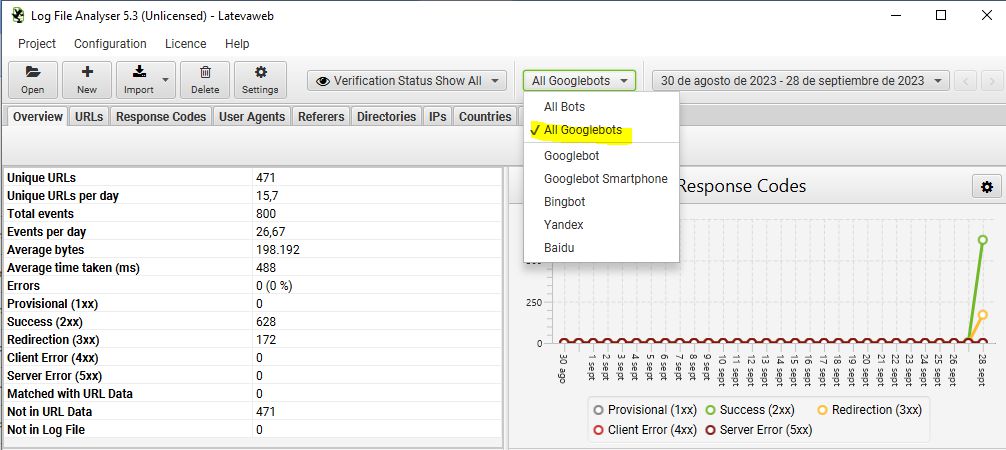

Pero si tenemos nuestro foco en Google, la herramienta nos permite filtrar los datos sólo con las visitas de los bots de Google, incluso sólo de uno de ellos:

Además del

overview con datos generales de los logs, nos ofrece varias pestañas para ir analizando los datos troceados. Al final la información es la misma pero agrupada desde parámetros distintos:

- URLs: las páginas visitadas por el bot, las veces que se han visitado, el último código de respuesta obtenido o el peso de los archivos, entre otros

- Response codes: los eventos ordenados por códigos de respuesta

- User agents

- Referers: nos permite saber cuál ha sido la fuente que ha llevado a Google a descubrir tal recurso. Pueden ser URLs internas, pero también webs externas

- Directories: agrupación del contenido visitado en función de las carpetas de nuestro hosting

- IPs: recomendamos que cuando crees el proyecto marques la casilla para verificar sólo las visitas de Googlebot reales, y no las simuladas. En ese caso, todas las IP serán de Google (deberían empezar por 66.249).

- Países

- Events: normalmente vas a preferir ver los eventos agrupados por URLs, pero ahí los tienes todos

- Importación de datos externos: sirve por si queremos subir otros datos, por ejemplo un rastreo del spider del Screaming frog, para cruzarlo y compararlo con el rastreo real de Google. Permite encontrar URL huérfanas, por ejemplo.

Una vez obtenemos estos datos, es interesante analizarlos e intentar sacar conclusiones. Hay tablas enteras que nos pueden valer y nos las podemos exportar. Algunas sugerencias serían:

- Exportar los datos por URLs, ordenarlos por veces visitadas, y así cruzar lo que visita Google con lo que me interesa que visite

- Exportar la tabla de códigos de respuesta para aislar los 4XX, 5XX, o incluso los 3XX

- Exportar las URLs inconsistentes. Mejor evitar las de Googlebot Images, pues dan muchos 304 (no modificado), que no son un problema. Una URL inconsistente da resultados diferentes para distintos logs, con lo que podríamos estar ante problemas en nuestro servidor o código

3. Los registros de logs y el SEO

¿En qué logs nos debemos fijar los SEOs?

Si el análisis de logs lo estás realizando para analizar aspectos relacionados con el SEO, entonces debes fijarte esencialmente en los logs de los robots de rastreo de Google: Googlebot Smartphone, Googlebot Desktop y Googlebot Images esencialmente, aunque Google va diversificando los bots que utiliza para el índice.

Mediante el análisis de logs podemos saber qué robots visitan nuestro sitio, qué URLs visita y con qué frecuencia pasa por cada URL, entre otras informaciones interesantes.

Información relevante a extraer para SEO en un análisis de logs

- Eventos al día y su distribución

- Errores de rastreo

- URLs huérfanas

- Qué partes de la web y qué tipología de URLs rastrea más a menudo

Y a partir de esa información, lo procesaremos y casaremos con nuestras prioridades de negocio. Imaginemos que llevamos el SEO de una tienda online, cuyo principal objetivo es vender productos online, pero detectamos que los bots visitan a menudo páginas de blog y casi nunca las de categoría o producto. Estamos ante un problema de negocio que debemos acometer (ver post

Del SEO a kilo hacia el SEO orientado a negocio).

Al final

lo importante es identificar cuántas URLs irrelevantes está rastreando, y cuántas URLs relevantes no está rastreando lo suficiente. Pues nuestro primer objetivo como SEO será alcanzar una distribución eficiente de nuestro presupuesto de rastreo. Porque no olvidemos que el proceso de rastreo es el previo a la indexación y posterior rastreo.

Cuándo realizar un análisis de logs y monitorizarlos

Anteriormente hemos explicado que en una web pequeña no es necesario realizar un análisis de logs como los descritos en este post. Es difícil poner una cifra o tamaño, pero nos atreveríamos a decir que

para webs de menos de 10.000 URLs con Search Console tiras de sobras. En adelante, sí que es interesante realizar un análisis de logs cuando abras el proyecto y de vez en cuando. Para proyectos especialmente grandes, ahí sí que además de realizar un análisis inicial, deberías poner un protocolo de monitorización con rutinas y periodicidad fijadas, aunque dependerá de los recursos disponibles.

El análisis de logs y el Crawl Budget

Piensa en la cantidad de recursos que debe invertir Google en rastrear millones de páginas web cada día. No tiene recursos ilimitados, así que nos asigna un tiempo y tamaños de descarga a cada web. Entonces si tiene 30 segundos para registrar 5.000 recursos de nuestro sitio, así que va a intentar aprovechar al máximo este tiempo para obtener contenido de valor.

Los logs nos darán respuesta sobre si Google está invirtiendo el tiempo en consultar nuestro contenido relevante o no, y el reto realmente viene en nuestra capacidad de análisis y de toma de decisiones para su manipulación.

En consecuencia, algunas medidas que puedes tomar son:

- Identificar y eliminar el contenido duplicado

- Identificar y eliminar las URLs thin content

- Revisar páginas en No-index. Piensa que Google no va a perder tiempo en rastrear esas URLs. ¿las necesitas?

- Optimización WPO para que con un mejor rendimiento de mi web, pueda consultar más URLs en menos tiempo

- Identificar respuestas 4xx y 3xx, y en la medida de lo posible, corregirlas y conseguir el máximo de respuestas 200

- Evitar siempre que la tecnología lo permita, generar y enlazar URLs no canónicas (por ejemplo, con parámetros)

- Revisar los sitemaps: debe estar todo lo que queremos indexar, y sólo eso

- Manejo del archivo robots.txt para bloquear el acceso de los bots a determinados contenidos

Analizar qué archivos consultan los bots de Google en nuestra web es una práctica esencial SEO para proyectos grandes