Los filtros y facetas son elementos web que nos ayudan a ordenar y filtrar elementos de un conjunto de ítems web. Los filtros nos habilitan refinar resultados, prescindiendo de los que no nos interesan, mientras que las facetas nos permiten reordenar los elementos en función de nuestros criterios preferentes (precio, novedad, etc). Su principal función es de UX, en el sentido de facilitar la navegación del usuario hasta encontrar mejor lo que el usuario quiere, sin necesidad de perderse en un mar de paginaciones.

Generalmente se colocan los enlaces a la izquierda y las facetas en la parte superior, aunque esto no siempre es así, pues en ocasiones vamos a preferir dejar el lateral para elementos de sidebar, como enlaces a otras categorías o a promociones. A nivel SEO, los filtros y facetas nos plantean muchos problemas. Por lo general generan URLs parametrizadas no posicionables, y además consumen muchos recursos de rastreo a los bots de Google. Nos pueden generar infinitos problemas de contenido duplicado o thin content. Entonces, ¿cómo podemos tratar estas casuísticas?

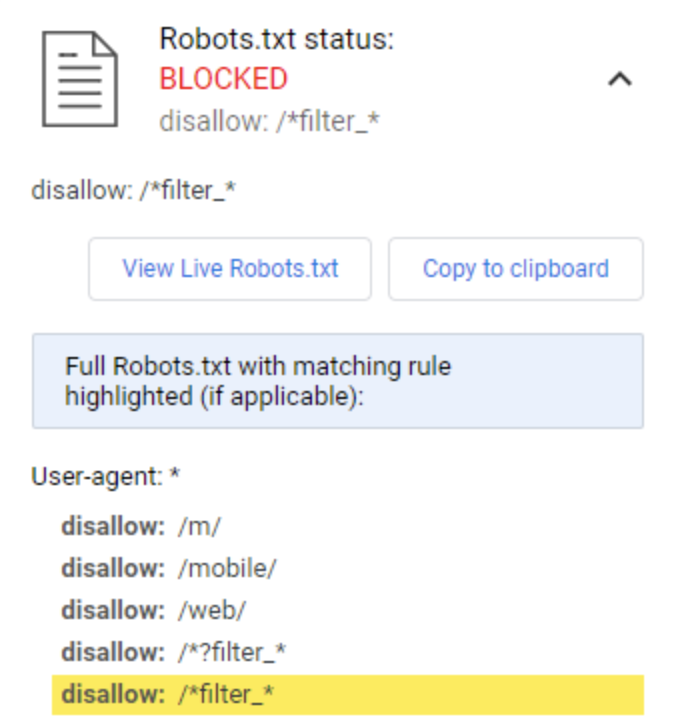

De este modo Google ni siquiera va a entrar a esas URLs, ahorrando recursos de rastreo y pudiéndolos invertir en aquellos que nos interesa de verdad.

Cuidado: si ya tenemos muchas URLs parametrizadas y queremos parar este proceso, primero debemos eliminarlas de las SERP, y luego bloquearlas, pues si las bloqueamos Google no va a poder acceder, ni siquiera para eliminarlas.

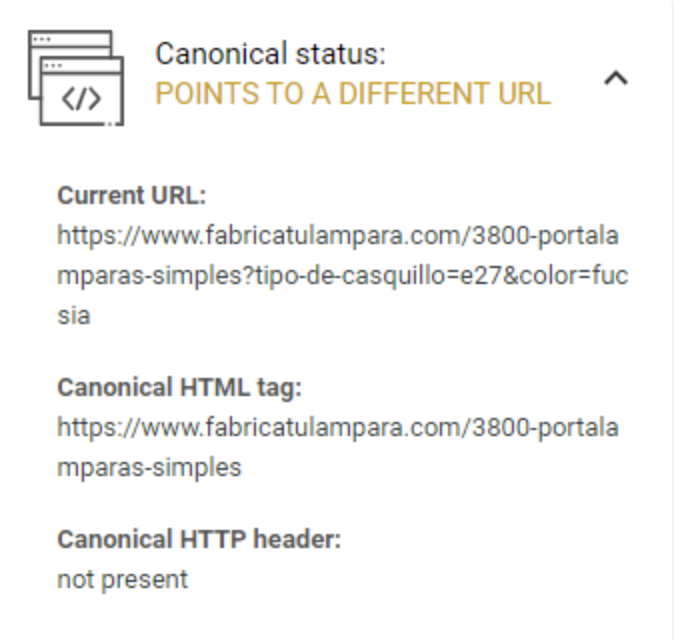

De este modo aunque puede acceder Google a esas URLs, no las debería indexar ya que le indicamos que la buena es la principal. Pero ojo, esto es opcional para Google y no siempre lo va a seguir. Además, las arañas de Google van a perder muchísimo tiempo rastreando URLs que luego tú mismo le indicas que no tienen valor, en vez de invertir su tiempo en rastrear otras URLs más interesantes a nivel SEO.

Esto es complejo, delicado y no siempre se va a poder hacer técnicamente. Lo que sugerimos aquí es que se pueda conservar la acción de filtro y facetado, pero que no incluyan un enlace como tal. Si no los enlazamos, preservamos el PageRank. Se puede maquetar la web o bien ofuscar los enlaces, para que Google no detecte eso como enlaces. O bien mantener el enlace pero ponerlo como nofollow. En cualquier caso son implementaciones complejas técnicamente y no tenemos garantías de que Google vaya a procesarlos como esperamos, a menos que tengamos un buen equipo de IT y recursos de seguimiento y monitorización, así como registros de logs y Google Search Console al día.

Como vimos anteriormente en el post sobre las paginaciones, la mejor forma de evitar los problemas SEO que nos acarrean los filtros y facetas es prescindir de ellos. Para webs muy grandes será prácticamente imposible, pero podríamos guiar al usuario a través de un entramado complejo de categorías y subcategorías, hasta llegar a listados de productos no muy extensos y optimizados para SEO. Esta solución es muy golosa para los SEOs, pero se priva al usuario de una funcionalidad muy útil y agradecida. Si ponemos el usuario en el centro, este camino lo deberíamos evitar.

Con los filtros y facetas ocurre lo contrario que nos pasa con las paginaciones. En este caso los usuarios los quieren, pero a los SEOs nos plantean problemas. En consecuencia, en un escenario SEO moderno donde el usuario y su experiencia son el centro, no podemos prescindir de filtros y facetas en webs medianas y grandes. A partir de ahí en este post hemos repasado las diferentes técnicas que a nivel de implementación nos permiten lidiarlos: bloquearlos por robots.txt, canonicar las URLs, o eliminar u ofuscar los enlaces internos. Teniendo todas las implementaciones imperfecciones, sin duda el bloqueo por robots.txt es la forma más sencilla, limpia y cumple perfectamente con las recomendaciones de Google. Así que si es técnicamente viable, sería siempre nuestra recomendación.

¿Tienes un proyecto en mente? Cuéntanoslo

Hay varias estrategias para corregir los problemas de rastreo e indexación que filtros y facetas nos generan